Hadoop/Spark 之重

轻量级的选择

SPL 集群计算的代码也非常简单,比如前面提到的订单分析计算,具体要求是:大订单表分段存储在 4 个节点上,小产品表则加载到每个节点的内存中,两表关联之后要按照产品供应商分组汇总订单金额。用 SPL 写出来大致是下面这样:

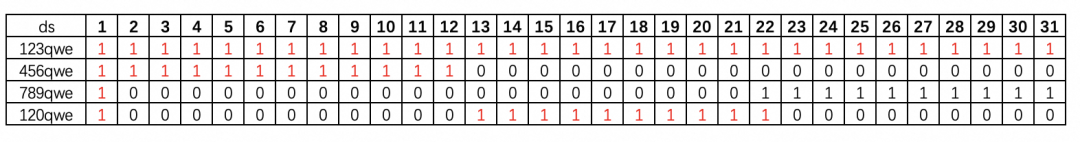

A

B

1

[“192.168.0.101:8281″,”192.168.0.102:8281”,…, “192.168.0.104:8281”]

2

fork to(4);A1

=file(“product.ctx”).open().import()

3

>env(PRODUCT,B2)

4

=memory(A1,PRODUCT)

5

=file(“orders.ctx”:to(4),A1).open().cursor(p_id,quantity)

6

=A5.switch(p_id,A4)

7

=A7.groups(p_id.vendor;sum(p_id.price*quantity))

这段代码执行时,任务管理(内存加载、任务拆分、合并等)所需要的计算资源,远远小于关联和分组汇总计算的消耗。如此轻便的任务管理功能,可以在任意节点、甚至是集成开发环境 IDE 上执行。

SPL 既轻且快

https://github.com/SPLWare/esProc

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容