当前,整个科技圈都在为”智能体(Agent)”而狂热。

而在这股热潮中,最让数据从业者兴奋的,莫过于”Data Agent”——你说一句话,AI就能自动写SQL、连数据库、生成图表、输出日报,甚至还能”解释一下数据背后的业务含义”。

Data Agent,就像你训练了一个会分析的分身

你交给他一个任务:”研究一下上季度销售额下滑的原因,并找出TOP 5的潜力客户。”

你不需要教他SQL语法,也不需要告诉他数据存在哪个库的哪张表。

你只需要给他授权:

规划能力

第一步:

第二步:

第三步:

第四步:

第五步:

这个拥有大语言模型(LLM)作为”大脑”的分身,就是Data Agent。

它不是被动执行命令的脚本,而是一个能自主规划、调用工具、并从环境中学习的智能体。

LLM的出现,为几十年前那个关于Agent的梦想,注入了真正的”灵魂”。

看起来很美,但我要先浇一盆冷水

它看起来像数据智能化的终极形态,似乎要让数据分析师”连SQL都不用写了”。

各大厂商的Demo一个比一个炫酷:自然语言提问,实时图表呈现,仿佛我们与数据之间的一切技术障碍都被抹平了。

但今天,我先浇一盆冷水。

听得懂人话的实习生

它反应快、不抱怨、看似聪明,但你真敢把核心任务交给它吗?

它缺乏业务常识,做事不过脑子,随时可能给你一个”看起来很对”的灾难性结果。

你让它帮你分析上个月的GMV,它可能连公司对GMV的官方定义都没搞清楚。

技术给了我们一把看似能打开未来的钥匙,但门后面不是一片光明,而是更复杂的工程、组织和信任挑战。

这篇文章,帮大家一层层拆开那个光鲜的Demo外壳,看看Data-Agent要想从一个”聪明的实习生”真正成长为能”上岗”的专家,到底还缺了点什么。

一、技术上远未成熟

Data Agent的诞生,得益于大语言模型(LLM)惊人的自然语言理解能力。

语言建模逻辑推理

它是一个基于概率的”下一个词”预测器,而不是一个能理解因果、懂得权衡的决策引擎。

这种底层机制的差异,导致了Data Agent在看似智能的表象下,隐藏着一系列致命的技术短板。

1. 它能听懂”人话”,但听不懂”行话”

这是最普遍的陷阱。

当业务人员问:”我想看看上月华东地区GMV有没有下滑?”

Agent能准确识别出”上月”(时间)、”华东”(地点)、”GMV”(指标)。

但它在执行时,几乎必然会犯错:

▶ 指标口径的错位

它可能会直接去抓一个叫 order_amount的字段,但公司内部对GMV的统一定义却是”支付成功的订单金额”,并且要排除某些刷单订单。

这个业务规则,LLM不知道。

▶ 维度的混淆

数据库里可能存的是 province_code,但Agent根据字面意思去找 region_name,结果自然是查无此列或关联错误。

▶ 隐性上下文的缺失

“上月”是自然月还是财务月?新老用户的划分标准是什么?

这些 unspoken rules(潜规则)存在于分析师的脑子里,却不存在于冰冷的数据表结构中。

所以,Agent不是不聪明,而是面对一个没有被清晰治理、充满”行话”和”土话”的数据环境,再聪明的AI也只能”瞎猜”。

高概率的语义正确,伴随着高风险的业务逻辑错误

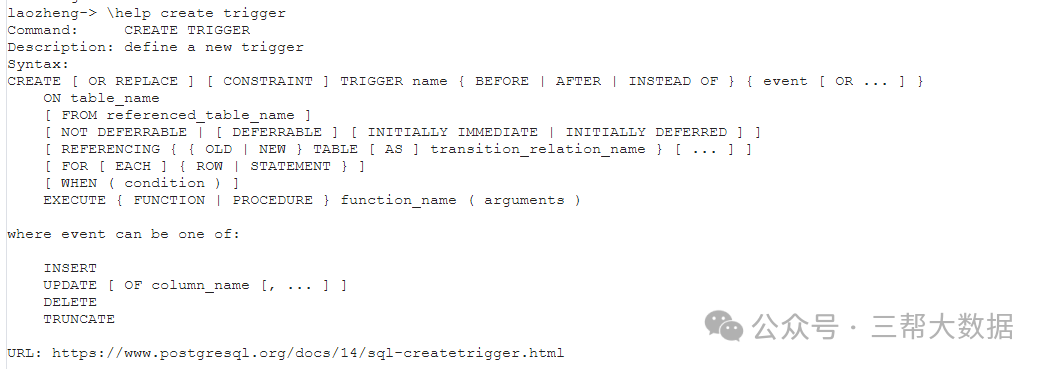

2. 它会写SQL,但随时可能写出”灾难级”代码

生成SQL是Data Agent最直观的能力,也是它最容易”露怯”的地方。

除了前面提到的字段、口径错误,它生成的SQL还常常是性能灾难。

一条看似简单的查询,可能因为不合理的JOIN、缺失的过滤条件,直接导致”全表扫描”,瞬间打垮你的数据仓库。

更可怕的是,LLM的本能是”自信输出”。

它不会告诉你:”这条SQL我不太确定,可能会很慢,要不要优化一下?”

它只会直接把那条可能导致数据库宕机的代码扔给你。

3. “幻觉”不是Bug,是它的出厂设置

我们必须反复强调:幻觉(Hallucination)是LLM的常态。

在数据分析场景,这种幻觉是致命的:

比如:”数据显示,本月用户活跃度大幅下降,建议市场部门关注渠道投放效率。”

形式上无懈可击,实质上胡说八道

因为它会诱导你做出错误的决策,而你甚至都没有意识到信息的源头是错的。

4. 多Agent协作?更像是一场”草台班子”的演出

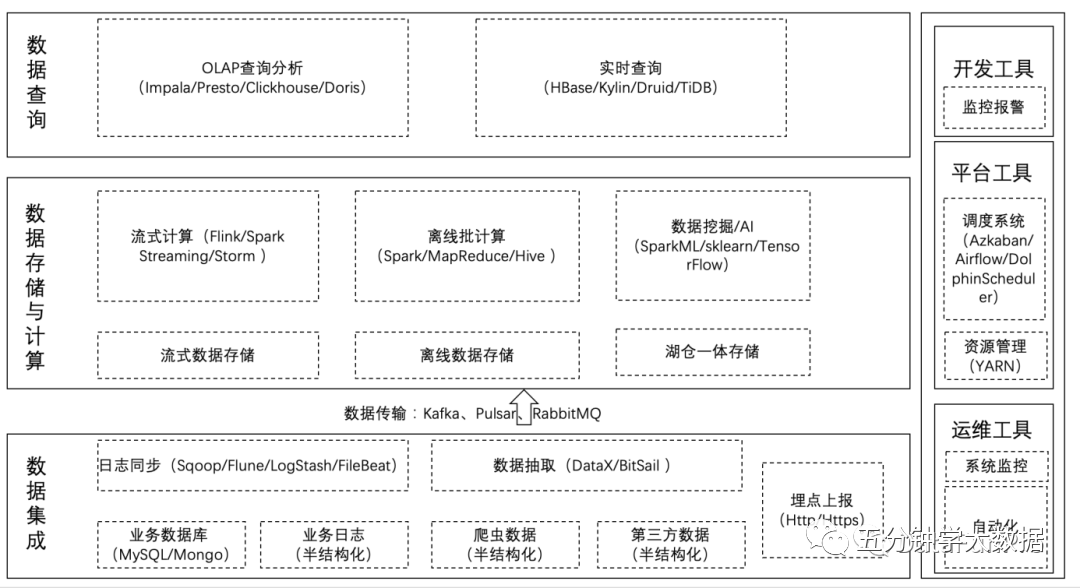

为了解决复杂任务,业界提出了”多智能体协作”的理念。

比如一个Agent负责理解意图,一个负责写SQL,一个负责可视化,一个负责总结报告。

听起来像一个分工明确的”AI梦之队”。

但现实是,这更像一个用胶水和脚本粘在一起的”草台班子”。

我们缺乏:

▶ 统一的Agent通信协议

任务如何交接?上下文如何传递?失败了谁来接管?目前全是各家自定义。

▶ 可靠的调度与编排系统

整个任务链的状态如何追踪?哪个Agent的优先级更高?出现异常如何处理?

这些工业级的能力基本是空白。

▶ 持久化的记忆与状态管理

大多数Agent的记忆是短暂的,刷新一下页面,刚才那个聪明的”团队”可能就把你的问题忘得一干二净。

本质上,今天的多Agent系统还停留在”演示”阶段,离工业级的稳定可靠,还有很长的路要走。

二、一些有益的探索

当然,指出问题不是为了唱衰。

事实上,业界最顶尖的研究者们早已意识到了这些局限,并且正在探索一条更具前景的进化路径:

让Data Agent从一个只能看地图的”静态分析师”,进化成一个能亲自上街勘察的”主动探索者”

1. 自我驱动的探索(SDE-SQL)

传统的NL2SQL方法,是把数据库的”地图”(Schema,即表结构)一次性交给LLM,让它看图说话。

但如果地图信息不完整或有歧义怎么办?

SDE-SQL(Self-Driven Exploration)

SQL探针(SQL Probes)

这就像我们派实习生去写报告前,会先让他去做些调研:

这些”SQL探针”会主动去数据库里执行,把最新的、动态的、真实的数据情况反馈给LLM。

获得了这些一手信息后,LLM再生成最终的SQL查询,准确率自然大大提升。

这标志着Agent从一个被动的”应答者”,进化为了一个主动的”探索者”。

2. 应对海量数据的模式路由(DBCopilot)

在真实的企业环境中,数据表动辄成千上万张。

把这本”超厚的电话黄页”(海量Schema)全都塞给LLM,它有限的”大脑”(上下文窗口)根本处理不了。

DBCopilot

▶ 第一步:模式路由(Schema Routing)

路由器

智能前台

你用自然语言告诉它你要找什么,它能迅速在成千上万张表中,帮你定位到最相关的那几张表。

▶ 第二步:SQL生成

只有被”前台”筛选出来的、高度相关的几张表的”地图”,才会被交给真正的大牌专家——LLM。

此时,LLM可以心无旁骛地、高效地完成SQL生成任务。

这种”专业分工”的思路,是解决Data Agent在企业级规模化落地难题的关键。

三、落地的现实困境

想用但用不了

这已经不是技术问题,而是系统、组织和文化的挑战。

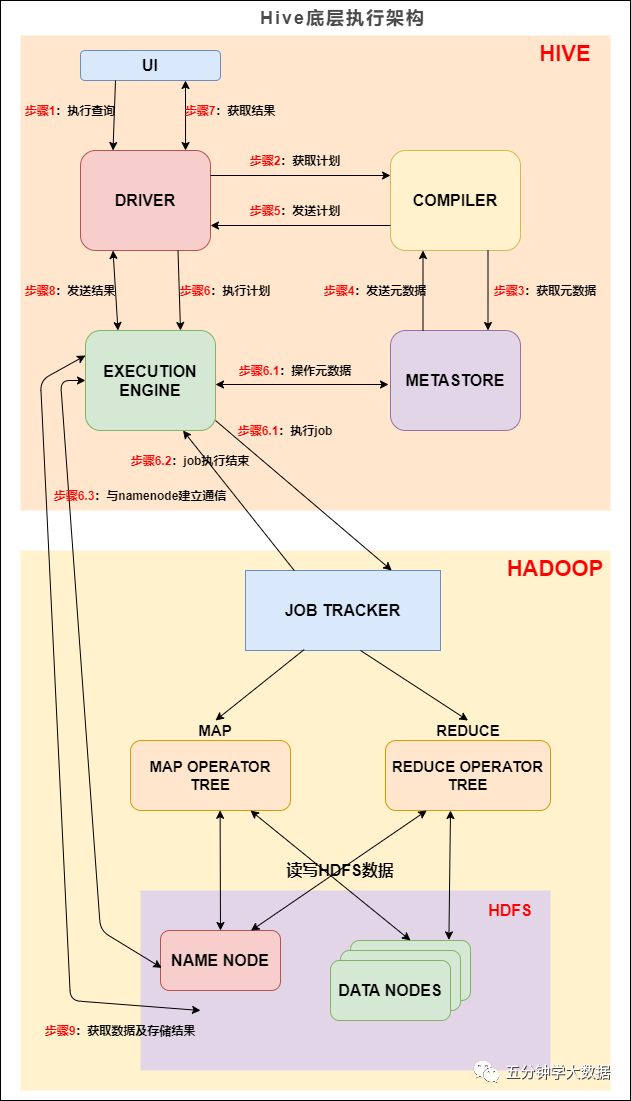

1. 系统集成:不是接入一个API,是”接入整个神经系统”

一个能上生产的Data Agent,需要无缝对接企业现有的复杂系统生态:

▶ 数据源

▶ 元数据系统

▶ 统一权限系统

▶ 审计与合规系统

把Agent接入进来,不是调用一个API那么简单,而是要在企业的”数据神经系统”中做一次大手术。

这需要”AI+数仓+工程+安全”的跨领域团队协同作战,其成本和难度远超预期。

2. 组织文化:决策者信人,不信”黑盒”

很多企业的数据文化,还停留在”信人而不信数”的阶段,现在要一步跨越到”信机器”?

这几乎不可能。

决策者会问:

分析师会想:

安全与法务担心:

在赢得组织的”信任”之前,Data Agent永远只能是一个”高级玩具”。

四、几点建议

对于正在考虑部署Data Agent的企业,少喊”全能AI分析师”的口号,一步一个脚印地走。

先把它当成一个能帮你”打杂”的实习生来用。

1. 先从这些”小场景”切入

风险低、回报快、逻辑清晰

▶ 日报自动生成

▶ 运营提数助手

▶ 元数据问答

▶ 分析师的”SQL草稿”生成器

2. 如何选择靠谱的”引路人”(供应商)?

在选型时,别再只盯着Demo有多炫酷、模型有多新。

我给你一个更务实的评估框架,围绕六个核心能力去考察:

场景适配能力

数据连接与权限

Agent系统能力

工程平台能力

模型适配与弹性

交付与服务能力

用以上标准去筛选,你会发现,那些只会”演”的供应商会很快现形,而那些真正懂数据、懂工程、懂企业的平台才会脱颖而出。

总结

Data Agent毫无疑问是激动人心的,它预示着一种全新的交互范式:

我们与数据之间的关系,正在从”操作”转向”对话”

它不会在短期内取代数据分析师,但它一定会深刻地改变分析师的工作方式。

它不会重构所有的BI系统,但它终将成为所有业务系统的一个”智能入口”。

对企业而言,Data Agent的浪潮无法回避。

但现在不是高谈阔论”颠覆”,而是踏踏实实”打基础”的时刻。

你需要做的,不是在今天就拥有一个无所不能的Data Agent,而是从一个小小的闭环场景开始,跑通一个流程,沉淀一套方法,建立一点信任。

暂无评论内容