在一个周五的深夜,老王被一通紧急电话从梦中叫醒。电话来自某零售巨头的首席营销官(CMO),他急需一份关于“本季度华东区新客转化率最高的营销活动及其关联的用户负面反馈”的报告,用于周一早上的战略会议。

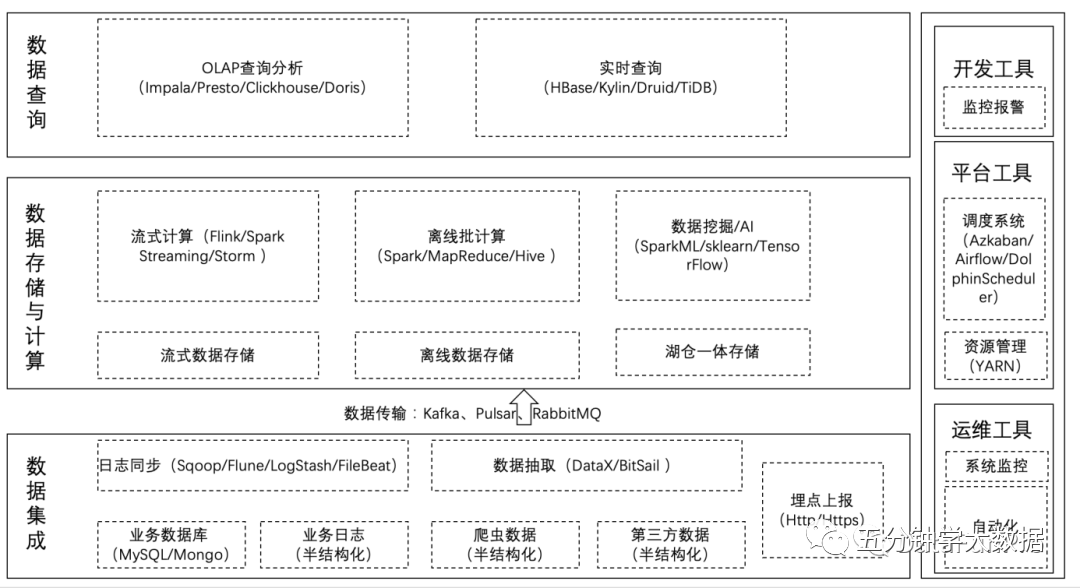

在当时,这几乎是个不可能完成的任务。为什么?因为所需的数据散落在三个完全隔离的“数据孤岛”里:

销售数据

营销活动记录

用户反馈

老王的团队连夜奋战,编写着脆弱的Python脚本,通过多个不同的API和数据库连接器艰难地“缝合”数据。每一步都心惊胆战,任何一个环节的微小变动——比如CRM系统的一个字段更新——都可能让整个脚本崩溃。

最终老王在周一凌晨完成了报告,但整个过程就像在数据沼泽中匍匐前进,效率低下且风险极高。

这次“救火”经历让老王深刻反思:虽然拥有强大的AI模型,它们擅长推理和总结,但为何在最需要它们的地方——贯通和理解复杂的业务数据时,却如此举步维艰?

根本原因在于,AI模型与公司的数据系统之间缺少一座标准化的桥梁。他们面临着一个“M×N”的集成难题:M个AI应用和N个数据源之间,需要开发M×N个独立的连接器。

模型上下文协议(Model-Context-Protocol, MCP)“AI领域的USB-C接口”

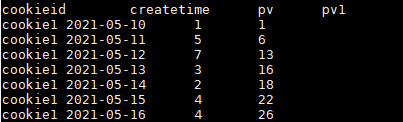

为了让大家更具体地理解MCP的价值,我们将深入一个典型的Text2SQL(自然语言转SQL)场景。业务用户不再需要编写复杂的SQL,只需用自然语言提问,系统就能自动查询数据库并返回答案。我们将构建一个MCP数据服务来实现这一功能。下面,我们先拆解其核心组件,再展示实现过程与最终效果。

一、服务核心组件介绍

Resources(资源)Tools(工具)Prompts(提示)

1、Resources(资源):让AI拥有“数据上下文”

概念

Resources是MCP Server向外暴露的数据和内容,是AI模型进行决策和推理的“上下文”或“背景知识”。它可以是任何类型的数据,如文件内容、数据库记录、API响应等。每个Resource由一个唯一的URI(统一资源标识符)标识。

应用场景

在我们的Text2SQL服务中,Resources至关重要。AI模型在生成SQL之前,必须先“学习”数据库的结构。因此,我们将数据库的元数据(metadata)作为Resources暴露出去。例如:

mcp://db-server/resources/tables: 一个文本资源,列出数据库中所有的表名。

mcp://db-server/resources/schema?table=Orders: 一个文本资源,返回“Orders”表的详细结构(列名、数据类型、注释)。

mcp://db-server/resources/relations: 一个文本资源,描述表与表之间的外键关联关系。

mcp://db-server/resources/sample_data?table=Products&rows=5: 一个文本资源,提供“Products”表的前5行抽样数据,帮助AI理解字段的具体内容。

2、Tools(工具):赋予AI“行动能力”

概念

Tools是MCP Server暴露的可执行函数,允许AI模型(通过客户端)调用它们来与外部世界交互、执行操作。这是AI从“思考者”变为“行动者”的关键。

应用场景

在Text2SQL服务中,最核心的“行动”就是执行SQL查询。我们将定义一个 execute_sql工具:

只读的安全是第一要义

3、Prompts(提示):指挥AI“工作流程”

概念

Prompts是预定义的、可复用的提示模板。它像一份“工作手册”,指导AI如何一步步完成特定任务。它可以动态地接受参数,并编排对Resources和Tools的调用顺序。

应用场景

我们将设计一个核心的 text-to-sql Prompt。这份“工作手册”会告诉AI模型:

“你的角色是一个数据分析专家。” “接到用户的自然语言问题后,

第一步

第二步

第三步

第四步

通过这三大组件的精妙配合,我们构建了一个既懂数据、又能行动、还听指挥的智能数据服务。

二、MCP数据服务实现

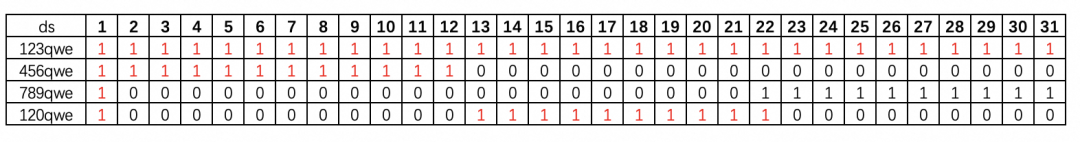

下面我们以一个电商数据库为例,展示具体实现。该数据库包含四张表: Users(用户表)、 Orders(订单表)、 Order_items(订单明细表)和 Products(商品表),其关系如下图所示:

(示意图:Orders.user_id -> Users.id; Order_items.order_id -> Orders.id; Order_items.product_id -> Products.id)

1、Resources 实现

我们将数据库的元数据封装为四个核心资源。

2、Tools 实现

我们实现一个核心工具,用于执行只读的SQL查询。

3、Prompts 实现

我们创建一个 text-to-sql提示,来串联整个工作流。

三、数据服务功能验证

现在,我们的MCP数据服务已经准备就绪。让我们看看它如何处理用户的真实请求。

场景一:总量统计

用户提问

AI执行流程

1、AI通过 text-to-sql提示接收任务。

2、(调用Resource) AI发现问题很简单,可能只需要一张表。它调用 /resources/tables,看到了 Orders表。

3、(构建SQL) AI构建SQL: SELECT COUNT(*)FROMOrders;

4、(调用Tool) AI调用工具 execute_sql,传入该SQL。

5、(获取结果) 工具返回 {“result”:[{“COUNT(*)”:15230}]}。

6、(生成答案) AI总结道:“数据库中总共有 15230 个订单。”

场景二:维度分类统计

用户提问

AI执行流程

1、AI接收任务。

2、(调用Resource) AI调用 /resources/schema?table=Orders,发现 Orders表中有一个 status字段。

3、(构建SQL) AI构建SQL: SELECT status,COUNT(*)FROMOrdersGROUP BY status;

4、(调用Tool) AI调用 execute_sql工具。

(获取结果)

(生成答案)

场景三:跨表关联统计

用户提问

AI执行流程(更复杂的思考链)

1、AI接收任务。

(调用Resource)

(调用Tool)

(获取结果)

(生成答案)

四、总结

ResourcesToolsPrompts

这种架构不仅极大地提升了数据查询的效率与易用性,更重要的是,它提供了一种安全、可扩展的范式。对于广大数据从业者而言,拥抱MCP意味着一次角色的转变——从疲于奔命的“数据管道工”,转变为高瞻远瞩的“数据服务架构师”。

未来,随着业务场景的深化,我们可以轻松地加入更多的工具(如数据可视化、异常检测工具)和更丰富的资源(如接入实时数据流),让MCP服务网络不断进化,最终成为企业数据智能化的核心基础设施,真正释放AI在业务决策中的价值,引领我们的数据应用,从“孤岛时代”迈向真正的“万物互联”时代。

暂无评论内容